大语言模型的快速发展正在深刻改变软件工程、自然语言处理等多个领域,但其在可靠性、鲁棒性与可解释性等方面的可信风险日益突出。针对当前缺乏系统性质量分析与保障体系的问题,研究团队提出了通用模型化分析框架,首次建立了基于模型化分析的面向大语言模型的系统化质量分析与可信评估理论体系。

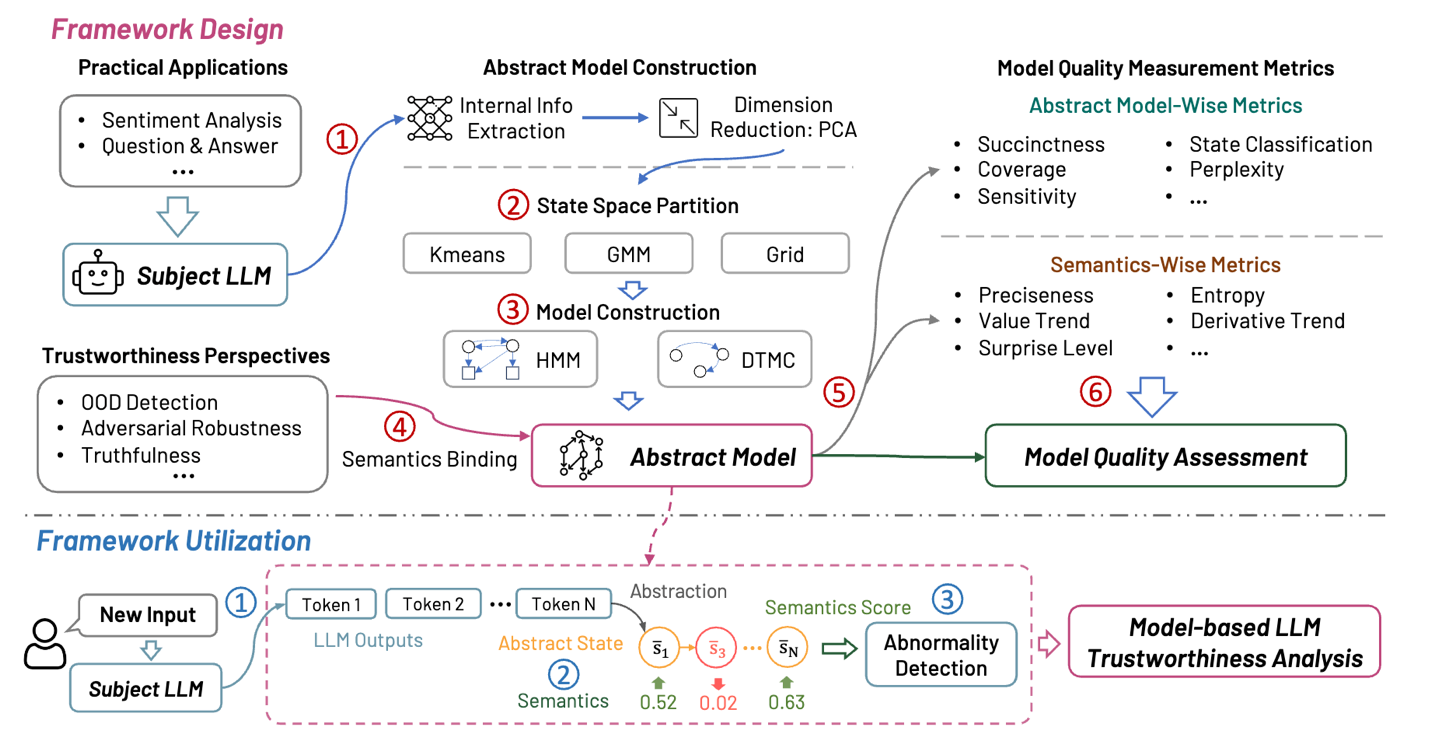

该研究创新性地提出了基于模型抽象与语义绑定的可信性分析方法,可从鲁棒性、安全性与一致性等多维视角,对大语言模型的行为特征进行可解释化的评估。LUNA框架具备良好的通用性与可扩展性,可支持包括分布外数据检测(Out-of-Distribution Detection)、对抗鲁棒性评估(Adversarial Robustness)与幻觉检测(Hallucination Detection)等关键任务。通过构建抽象模型并引入语义层级度量,该方法实现了对大语言模型异常行为的系统识别与分析,为人工智能系统的可信保障提供了可复用的理论与工具基础。

在大规模实证研究中,LUNA框架针对三个可信性维度开展了180组配置实验,验证了模型化分析在异常检测中的高效性与泛化能力。实验结果表明,LUNA不仅能准确区分大语言模型的正常与异常行为,其模型质量度量指标还可为后续的自动化质量保障研究提供参考依据。

该研究以“LUNA: A Model-Based Universal Analysis Framework for Large Language Models”为题发表于IEEE Transactions on Software Engineering (TSE)。论文第一作者为山东大学助理研究员宋达,通讯作者为加拿大阿尔伯塔大学和东京大学联合任职的马雷教授。